Da poco ho provato DALL-E: un tool di generazione immagini che ha dell’incredibile. Le immagini che ho generato per l’articolo mi hanno emozionato.

Oggi leggo un nuovo tassello verso l’immaginazione dell’AI: stavolta proviene da Google Deepmind e si chiama Transframer.

Leggiamo insieme la descrizione del modello:

Abstract

Presentiamo un modello generico per la modellazione delle immagini basate sulle attività di visione e la previsione probabilistica dei fotogrammi.

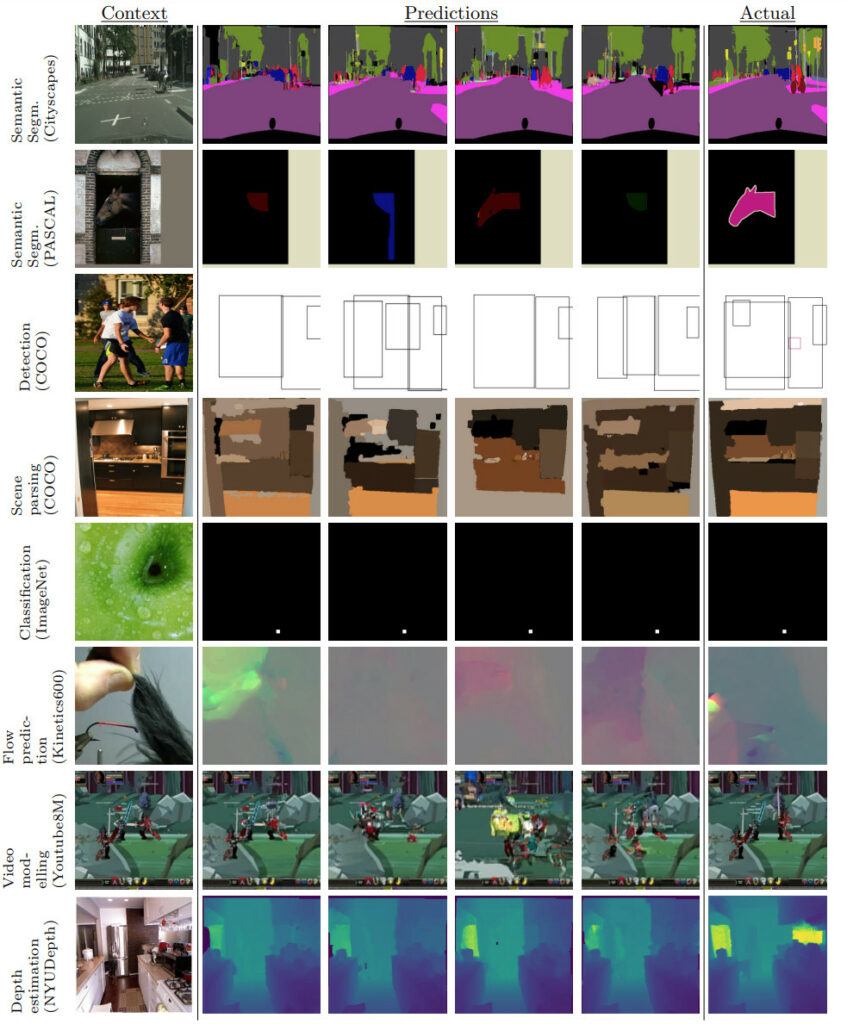

Il nostro approccio unifica una vasta gamma di compiti, dalla segmentazione delle immagini, alla sintesi di nuove viste e all’interpolazione video.

Accoppiamo questo framework con un’architettura che chiamiamo Transframer, che utilizza componenti U-Net e Transformer per condizionare i fotogrammi di contesto annotati e produce sequenze di immagini sparse e compresse.

Transframer è all’avanguardia su una varietà di benchmark di generazione video, è competitivo con i modelli più forti sulla sintesi della vista a pochi scatti e può generare video coerenti di 30 secondi da una singola immagine senza alcuna informazione geometrica esplicita.

Un singolo transframer generalista produce contemporaneamente risultati promettenti su 8 attività, tra cui la segmentazione semantica, la classificazione delle immagini e la previsione del flusso ottico senza componenti architettonici specifici per attività, dimostrando che la visione artificiale multi-task può essere affrontata utilizzando modelli di immagine probabilistici.

Il nostro approccio può in linea di principio essere applicato a una vasta gamma di applicazioni che richiedono l’apprendimento della struttura condizionale dei dati formattati con immagini annotate.

Tutto molto bello, ma funziona?

Sul sito di riferimento ci sono alcuni video a bassa risoluzione ed un po’ deludenti, ma che lasciano intravedere un futuro radioso: presto unendo le forze dei generatori di immagine e dei Transframer potremo dare in pasto direttamente le sceneggiature, lo stile, e vedere il film.

Okay: ci vorrà un po’ di tempo.